深度学习常用的算法有三种:卷积神经网络、循环神经网络和生成对抗网络。常见的深度学习算法有三种:反卷积神经网络、循环神经网络、生成对策网络,深度学习算法有哪些?常见的深度学习算法有三种:卷积神经网络、循环神经网络和生成对抗网络,有哪些深度神经网络模型?卷积细胞与前馈神经元非常相似,只是它们只连接到前一个神经细胞层的一些神经元。

1、简述深度学习的基本方法。

深度学习算法有三种:回归算法。回归算法是一种试图通过测量误差来探索变量之间关系的算法,是统计机器学习的利器。基于案例的算法。深度学习常用的算法有三种:卷积神经网络、循环神经网络和生成对抗网络。ConvolutionalNeuralNetworks(CNN)是一种具有深度结构的前馈神经网络,包含卷积计算,是深度学习的代表性算法之一。

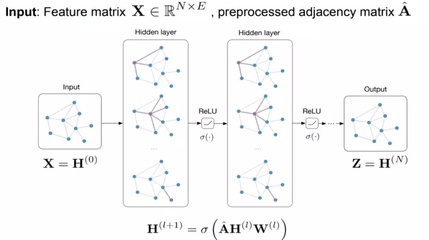

机器学习是一个很大的方向,包括很多方法,比如深度学习、GMM、SVM、HMM、dictionarylearning、knn和Adaboosting。不同的方法会使用不同的模型、不同的假设和不同的解决方案。

2、深度学习算法有哪些

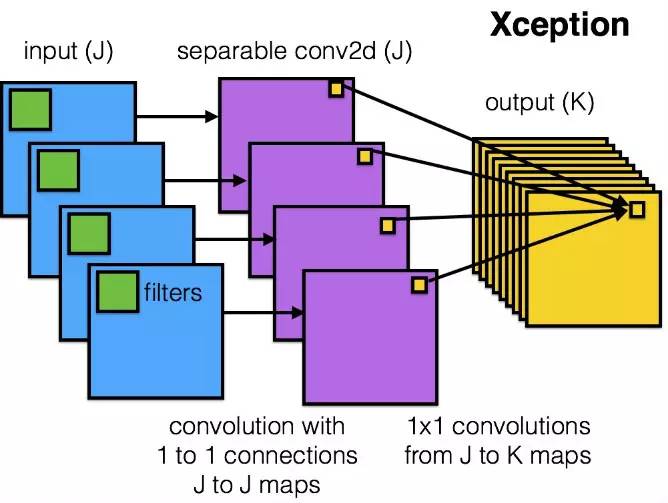

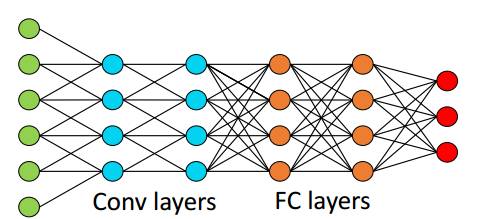

深度学习常用的算法有三种:卷积神经网络、循环神经网络和生成对抗网络。ConvolutionalNeuralNetworks(CNN)是一种具有深度结构的前馈神经网络,包含卷积计算,是深度学习的代表性算法之一。常见的深度学习算法有三种:反卷积神经网络、循环神经网络、生成对策网络。

3、请问卷积神经网络的概念谁最早在学术界提出的?

福岛邦彦。2021年4月29日,KunihikoFukushima获得了2021年鲍尔科学成就奖。他在深度学习方面做出了卓越的贡献,最有影响力的工作是“Neocognitron”卷积神经网络架构。事实上,熟悉于尔根施米德胡伯的人都知道,他一直担心自己在深度学习领域的早期原创成果没有得到业界的广泛认可。

很奇怪,对吧?但这个Neocognitron,用今天的话来说,叫做卷积神经网络(CNN),是目前深度神经网络基础结构最伟大的发明之一,也是人工智能的核心技术。什么?卷积神经网络不是一个叫YannLeCun的大人物发明的吗?为什么改成了KunihikoFukushima?严格来说,LeCun是利用误差反向传播训练卷积神经网络(CNN)结构的第一人,但他并不是发明这种结构的第一人。

4、CNN(卷积神经网络

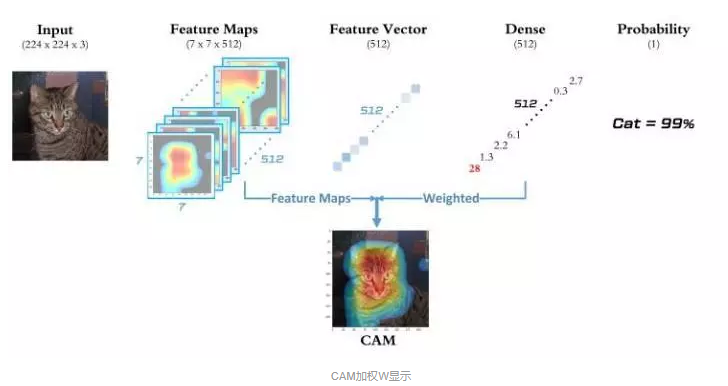

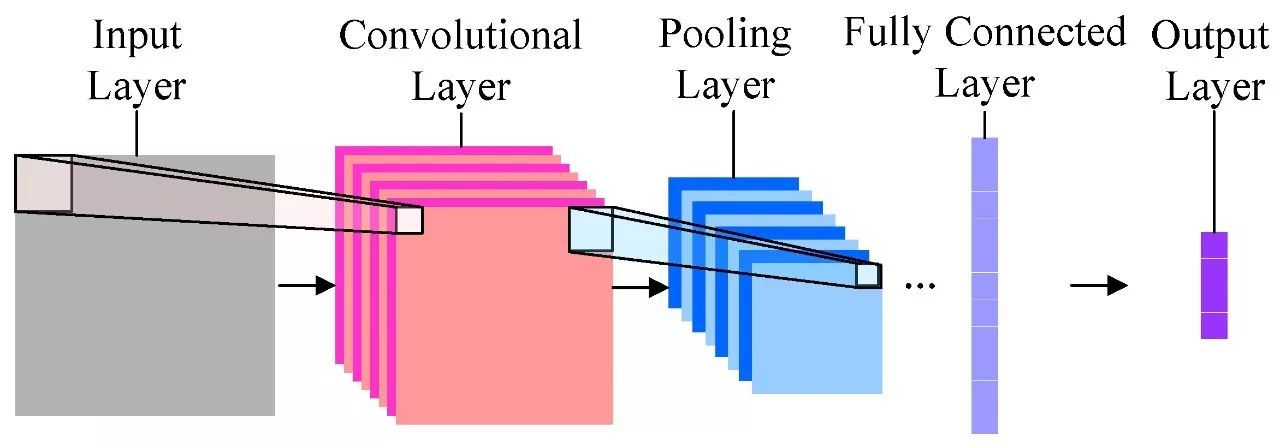

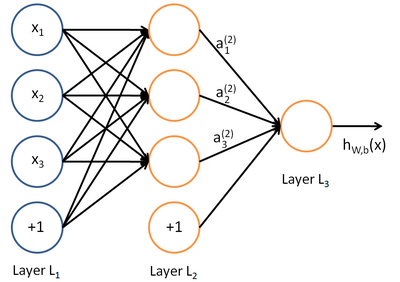

基础知识解释:卷积:通过两个函数F和G生成第三个函数的数学算子,用F和G的重叠函数值翻转平移后的乘积表示重叠长度的积分。前馈神经网络:每个神经元是分层排列的,每个神经元只与上一层的神经元相连,接收上一层的输出,输出到下一层。层间没有反馈。卷积神经网络是一种包含卷积计算且具有深度结构的前馈神经网络卷积核:即在图像处理中,给定一幅输入图像,输入图像中一个小区域内的像素经过加权平均后成为输出图像中每个对应的像素,其中权重由一个函数定义,称为卷积核。

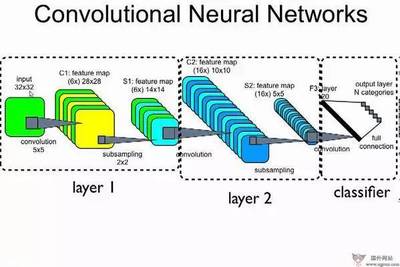

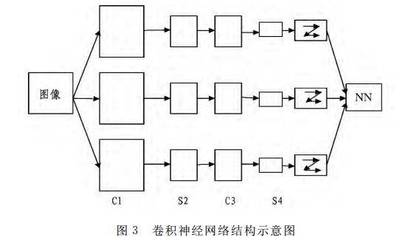

结构介绍输入层:用于数据输入的卷积层:使用卷积核进行特征提取和特征映射;非线性映射;卷积是线性映射,以弥补不足;汇集层:下采样;稀疏特征映射以减少数据计算;全连接层:在CNN尾部重新拟合,减少特征信息丢失;输入层:在CNN的输入层中,(图片)数据输入的格式与全连接神经网络(一维向量)的格式相同

5、有哪些深度神经网络模型

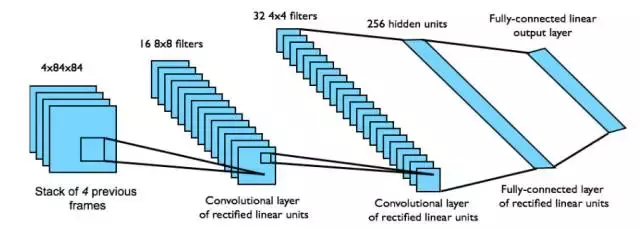

Convolutionalcells与前馈神经元非常相似,只是它们只连接到前一个神经细胞层的某些神经元上。因为它们不是随机与某些神经元相连,而是与特定范围内的神经元相连,所以通常用来保存空间信息。这使得它们对于那些拥有大量本地信息的人来说非常实用,比如图像数据和语音数据(但大多数情况下是图像数据)。去卷积神经元正好相反:它们通过与下一个神经细胞层连接来解码空间信息。

可以认为这些拷贝是放在结构相同的不同神经网络中。这两种神经元本质上都是一般意义上的神经元,只是使用方式不同。汇集神经元和插值单元通常与卷积神经元结合使用。它们不是真正意义上的神经元,只能进行一些简单的运算。接收到其他神经元的输出后,池化的神经元决定哪些值可以通过,哪些值不可以。

6、 深度卷积神经网络应用于量子计算机

量子计算机会被用来做什么?量子计算机有望帮助解决包括机器学习在内的许多领域的难题。本文详细描述了卷积神经网络(CNN)在量子计算机上的理论实现。我们把这个算法叫做QCNN,我们证明它比CNN运行速度快,准确率高。因此,我们必须提出卷积乘积的量子形式,找到实现非线性和池化的方法,以及对图像的量子态进行层析的新方法,从而保留有意义的信息。

事实上,这些向量代表了许多可能观测值的叠加。另一方面,机器学习,尤其是神经网络,大致是用向量和矩阵来理解或处理数据。量子机器学习(QML)旨在用量子系统对向量进行编码,并用新的量子算法学习它们。一个关键的概念是在许多向量上使用量子叠加,我们可以同时处理它们。我不会更深入地介绍量子计算或QML。

7、深度卷积网络

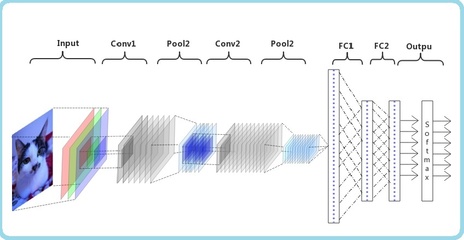

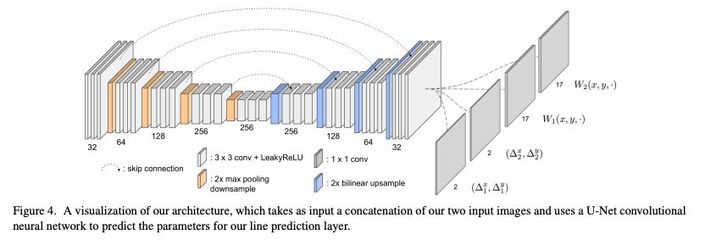

LeNet网络的结构如下图所示。可以看出,LeNet网络不使用填充。每进行一次卷积,图像的高度和宽度都会减小,而通道数会增加。全连通层有400个节点,每个极点有120个神经元,有时从这400个节点中提取一些节点来构造一个全连通层,即有两个全连通层。在这个网络中,最后一步是使用84个特征来获得最终输出。一开始网络用的是sigmoid函数tanh函数,现在往往倾向于用softmax函数。

AlexNet以论文第一作者命名。网络的结构如下图所示,网络的输出层使用softmax函数,AlexNet网络比LeNet网络大,大约有6000万个参数。当用于训练图像和数据集时,它可以处理非常相似的基本积木块,这些积木块包含大量的隐藏单元,并且与LeNet网络不同的是,它使用了ReLu的激活功能。