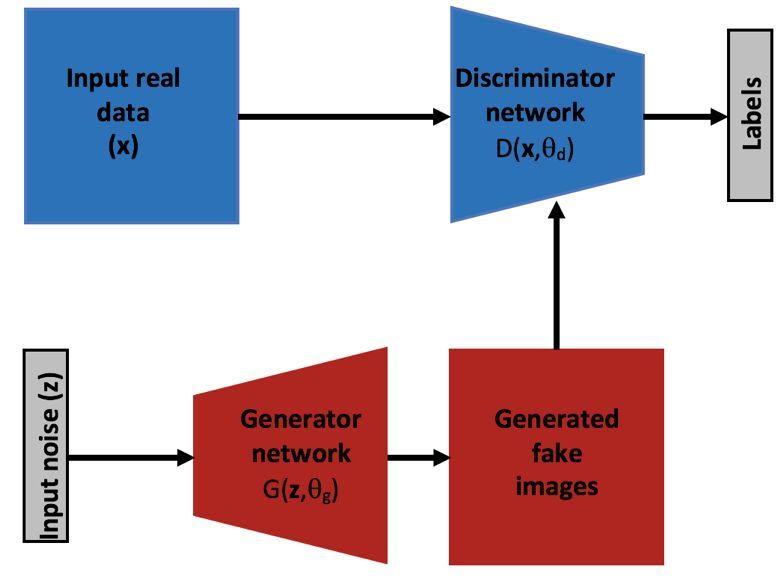

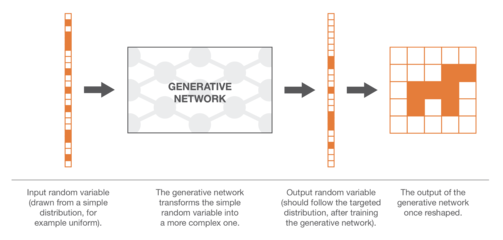

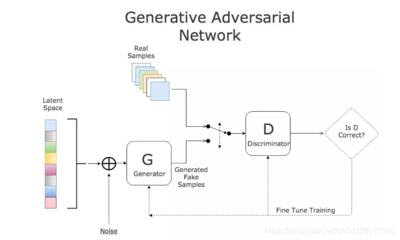

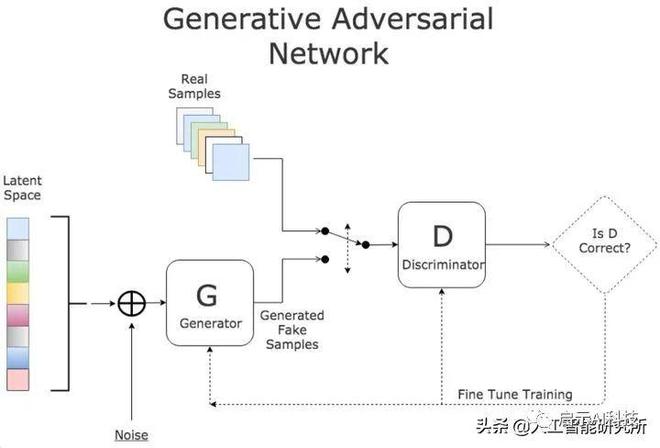

如何用TensorFlow实现生成式对抗网络前馈神经网络和反馈神经网络有什么区别?学习深度学习的基本模型,如卷积神经网络(CNN)、递归神经网络(RNN)和生成对策网络(GAN)。目前常用的深度神经网络模型主要有卷积神经网络(CNN)、递归神经网络(RNN)、置信度网络(DBN)、深度自动编码器(AutoEncoder)和生成对策网络(GAN)。

1、ai人工智能课程学什么

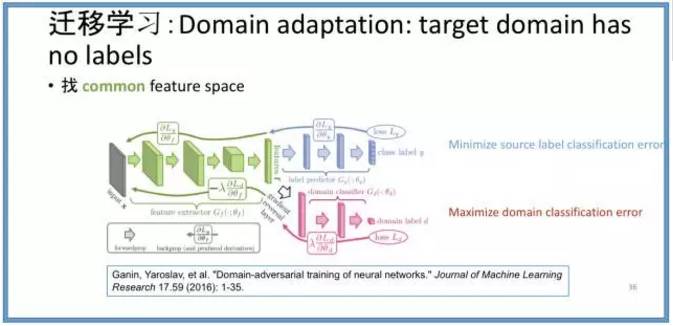

AI(人工智能)课程通常包括以下内容供你参考:1。机器学习基础:介绍机器学习的基本概念、算法和方法,如监督学习、无监督学习和强化学习。学习机器学习的数学基础,比如线性代数,概率论,统计学。2.深度学习:深度学习是机器学习的一个分支,涉及神经网络的构建、训练和应用。学习深度学习的基本模型,如卷积神经网络(CNN)、递归神经网络(RNN)和生成对策网络(GAN)。

4.计算机视觉:学习图像和视频数据的处理和分析技术,包括图像分类、物体检测、图像生成等。5.数据挖掘与大数据:学习从大规模数据中提取有用信息的技术和工具,包括数据预处理、特征选择、聚类和分类。6.强化学习(Reinforcement learning):学习在特定环境下,通过与环境的交互来学习最优策略的技术,适用于自主决策和控制领域。7.人工智能的伦理与法律:研究人工智能的伦理原则、法律规定和社会影响,探讨人工智能的道德和社会责任。

2、(

损失函数。损失函数用于通过神经网络的计算模型来评估样本的预测值与真实值之间的误差。目前常用的深度神经网络模型主要有卷积神经网络(CNN)、递归神经网络(RNN)、置信度网络(DBN)、深度自动编码器(AutoEncoder)和生成对策网络(GAN)。自从模拟人类实际神经网络的数学方法问世以来,人们已经逐渐习惯于将这种人工神经网络直接称为神经网络。

3、如何用TensorFlow实现生成式对抗网络

4、前馈式神经网络与反馈式神经网络有何不同?

前馈神经网络和反馈神经网络的主要区别在于神经元的状态不同。前馈神经网络的神经元状态更新只取决于输入,而反馈神经网络的神经元状态更新不仅取决于输入,还取决于神经元本身的状态。反馈神经网络中的神经元具有记忆功能,在不同时刻具有不同的状态。前馈神经网络可以看作是一个函数,通过简单非线性函数的多次复合,实现从输入空间到输出空间的复杂映射。

反馈神经网络中的信息传播可以是单向的,也可以是双向的,因此可以用有向循环图或无向图来表示。常见的反馈神经网络包括递归神经网络(RNN)、Hopfield网络和Boltzmann机。为了进一步增强记忆网络的记忆容量,可以将其映射到外部存储单元和读写机制中,以保存网络的一些中间状态,这种网络称为记忆增强网络,比如神经图灵机。异同点如下:1。前馈神经网络的神经元状态更新仅取决于输入,而反馈神经网络的神经元状态更新不仅取决于输入,还取决于神经元本身的状态。

5、BEGAN边界平衡生成对抗网络

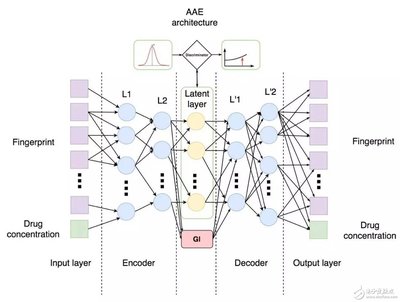

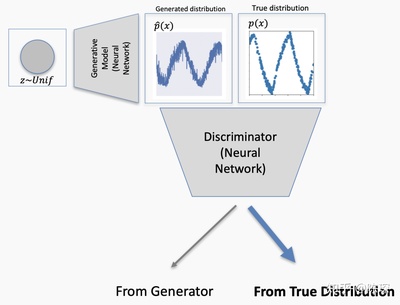

解决问题:GAN训练模型难度较大:BEGAN不直接估计生成分布pg与真实分布px之间的距离,而是估计两者分布误差之间的距离。如果分布之间的误差分布相似,也可以认为pg和px相似。begin将鉴别器G设计为自编码器,以重构分布误差,优化分布误差之间的距离,具体如下:begin提出了均衡化的概念来平衡G和D的训练,使得GAN即使使用非常简单的网络,不需要BN、minibath等训练技能,也能得到很好的训练结果。

实验中发现BEGAN收敛快,G和D的训练均衡,但超参数的选取是经验的考验。1.使GAN有一个快速稳定的收敛标准训练过程。2.引入均衡的概念来均衡鉴频器和发生器的功率。3.提供一种新的方法来控制图像多样性和视觉质量之间的折衷。4.收敛的近似度量使用自动编码器作为鉴别器,使用Wasserstein距离导出的损耗(类似于我前面提到的KL散度,具有正定性、对称性和三角不等式)来匹配自动编码器的损耗分布。

6、神经网络中的对抗攻击与对抗样本

Anti-attack反攻击论文参考:神经网络耐人寻味的性质,神经网络有趣的特征,对fadversarialattacksondeepering in Company的威胁:Survey,以下简称“Survey”。图片经过适当修改后欺骗深度学习模型的可能性,1.比如理解:左边是一张可被GoogLeNet正常归类为熊猫的图片。加了一些噪点后,就变成了右边的图,肉眼来看,它还是一只熊猫,但GoogLeNet会判断它是一只长臂猿。